Nvidia RTX: tutti i dettagli e i migliori monitor per sfruttarle

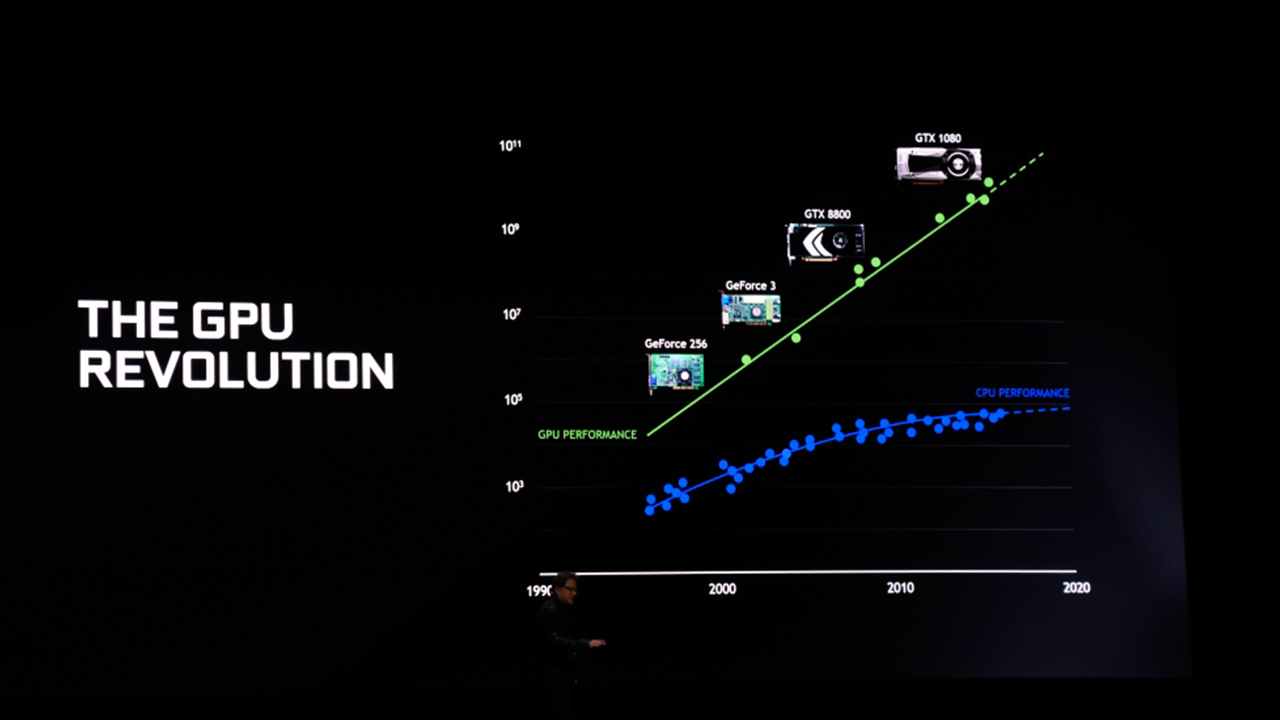

Poco tempo fa, è stata annunciata una nuova generazione di schede grafiche NVIDIA, marchio ormai garanzia per quanto riguarda il gaming ad alte prestazioni. Sono state presentate alla Gamescom, durante la quale l’amministratore delegato della società Jen-Hsun “Jensen” Huang ha rivelato la nuova serie di schede grafiche GeForce 20, con principale caratteristica, l’implementazione in hardware del Ray Tracing. La sigla che segue il nome GeForce, GTX nelle famiglie precedenti, è stata cambiata in RTX, facendo riferimento proprio all’uso di questa tecnologia.

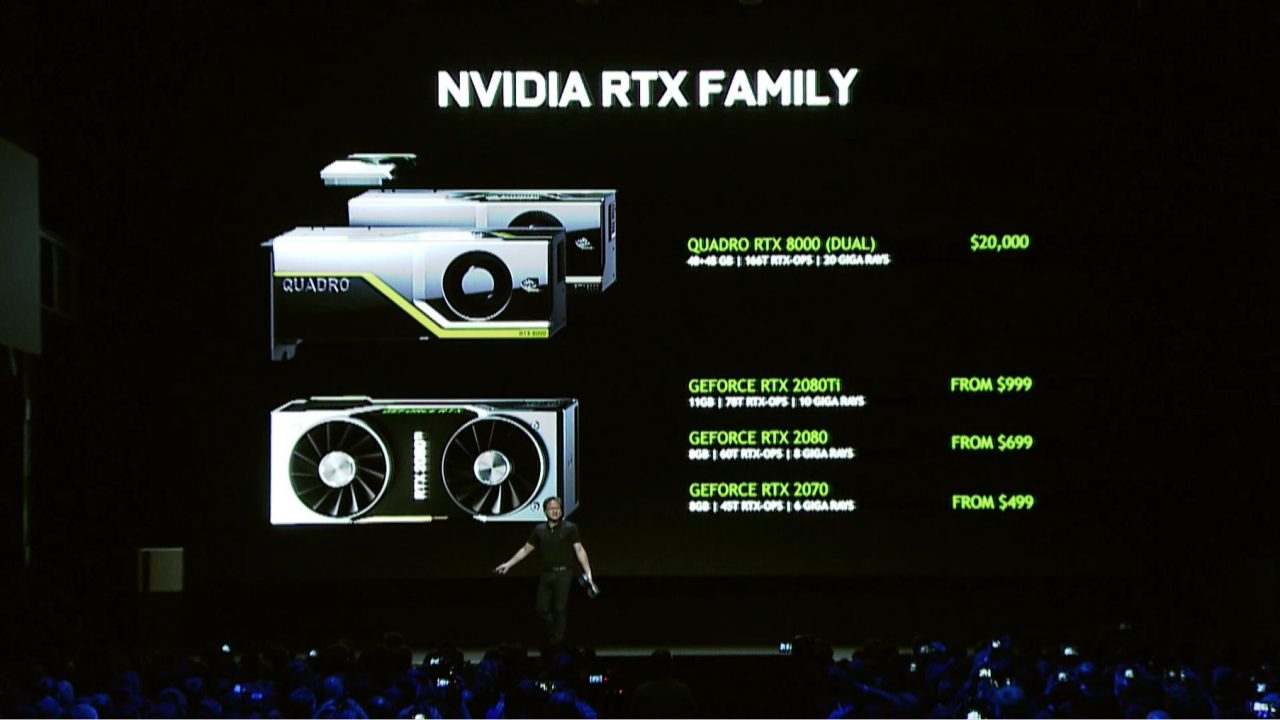

La più potente delle tre è la GeForce RTX 2080Ti, 4352 Cuda Core, 11 GB di memoria GDDR6 con ampiezza di banda di 616 GB/s. Ha bus memoria di 352-bit e la velocità di quest’ultima di 14 Gbps. La GPU ha valore di base 1350 MHz, ma raggiunge i 1635 Mhz in overclock. Per le “minori” , la GeForce RTX 2080 ha 23 Turing SM e 2944 CUDA core, mentre la RTX 2070 con 18 Turing SM e 2304 CUDA core. Ma esattamente in cosa consiste il Ray Tracing? Questa tecnica, consente il rendering della grafica in tempo reale, finora risultata difficile a causa dell’insufficiente capacità di elaborazione dell’hardware in commercio.

Ma esattamente in cosa consiste il Ray Tracing? Questa tecnica, consente il rendering della grafica in tempo reale, finora risultata difficile a causa dell’insufficiente capacità di elaborazione dell’hardware in commercio.

Consiste nel proiettamento dei raggi di luce dal punto di osservazione agli oggetti, i quali poi, rimbalzando nuovamente dagli oggetti al resto della scena, danno vita a una relazione fonte di luce – oggetto molto realistica, tutto basato su un algoritmo che segue il percorso tracciato da ogni singolo raggio al fine di determinare il colore del pixel su cui è proiettato, fermandosi non appena la destinazione risulta essere definitiva; in caso contrario viene gestito l’effetto conseguente di riflessione o rifrazione.

Nella tradizionale tecnica di rasterizzazione, l’illuminazione nella scena virtuale veniva gestita a partire dalla fonte di illuminazione, invece il Ray Tracing parte dal punto di osservazione.

Viene risolto quindi un problema di ottimizzazione creatosi con il progredire della qualità grafica dei videogiochi con rasterizzazione, dipendente dell’aumento delle fonti di illuminazione; avendo motori grafici supportanti l’illuminazione globale, il numero di fonti di illuminazione non è più importante quanto piuttosto il singolo pixel della scena.

Queste nuove schede rappresentano a tutti gli effetti una rivoluzione nel campo della grafica ad alte prestazioni, ed è stata anche coniata una nuova unità di misura, Giga Rays, per poter misurare la capacità di una specifica configurazione hardware di gestire il Ray Tracing. Ad esempio, gli RT core dell’architettura Turing elaborano 10 Giga Rays/s; in particolare, Jensen ha dichiarato che la RTX 1080 Ti è in grado di gestire 1,21 Giga Rays/s.

La nuova architettura Turing, caratteristica fondamentale delle nuove schede, in breve funziona così: in un primo momento partono shader e Ray Tracing, poi le operazioni in FP e INT. Infine, entrano in campo i Tensor Core. In futuro questi ultimi, potranno innalzare esponenzialmente la risoluzione di immagini non dettagliate, ottimizzando di molto il lavoro delle risorse hardware.

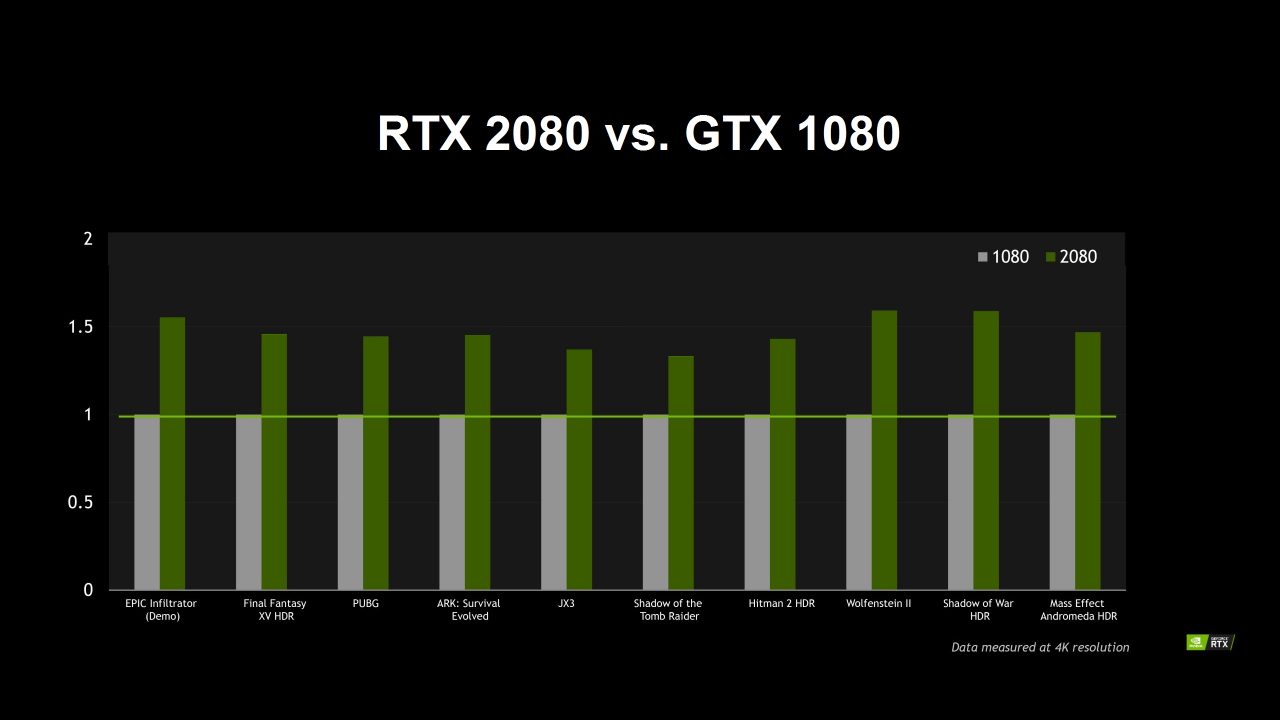

Stando ai benchmark forniti da Nvidia, le nuove RTX hanno un potenziale del 50% superiore in fatto di prestazioni rispetto alle schede precedenti con architettura Pascal, per quanto riguarda la gestione del Ray Tracing.

Ovviamente, le schede sono state confrontate mediante videogiochi tra cui Wolfenstein II: The New Colossus, Final Fantasy XV e Shadow of the Tomb Raider e, dati alla mano, la RTX 2080 ha il 150% della potenza rispetto alla GTX 1080, constatato anche tra 2070 e 1070, e addirittura tra 2080 Ti e 1080 Ti.

E mentre Shadow of the Tomb Raider non supera i 1080p e 40 fps, Battlefield V gira a 1080p con 60 frame al secondo sulla RTX 2080 Ti con Ray Tracing.

Secondo NVIDIA, il Ray Tracing verrà impiegato sempre di più nei giochi di prossima generazione, che l’architettura Turing permetterà di gestire con prestazioni decisamente superiori.

Chi volesse lasciare l’architettura Pascal per acquistare una scheda video Turing, dovrà fare i conti però con un prezzo che al momento è praticamente doppio, ma soprattutto perché sfruttare le nuove risorse richiede una forte limitazione in termini di risoluzione e frame rate, in particolare per quanto riguarda le 2070 e 2080.

Chi volesse lasciare l’architettura Pascal per acquistare una scheda video Turing, dovrà fare i conti però con un prezzo che al momento è praticamente doppio, ma soprattutto perché sfruttare le nuove risorse richiede una forte limitazione in termini di risoluzione e frame rate, in particolare per quanto riguarda le 2070 e 2080.

Pertanto, nonostante i monitor 4K siano l’ultima moda, se si vuole investire su una RTX per sfruttare il Ray Tracing, l’ideale sarebbe abbinarlo ad un televisore Full HD, ovvero composto da una griglia di pixel 1920 x 1080, detto anche 1080p, o a un Quad HD, con risoluzione 2560 x 1440.

A questo proposito, abbiamo stilato una lista dei migliori monitor per PC in Full HD e Quad HD.

HP 22W

Caratteristiche:

Caratteristiche:

- Pannello IPS da 21.5″

- Risoluzione Full HD (1920 x 1080)

- Refresh rate a 60 Hz

- Entrate video HDMI e VGA con cavo HDMI incluso

- Non provvisto di audio integrato

Prezzo consigliato: 129.99€

Prezzo attuale su Amazon: 89€

Samsung C24F390

Caratteristiche:

Caratteristiche:

- Pannello VA da 23.5″ curvo

- Risoluzione Full HD (1920 x 1080)

- Refresh rate a 60 Hz

- Entrate video HDMI e VGA con cavo HDMI incluso

- Non provvisto di audio integrato

Prezzo consigliato: 219€

Prezzo attuale su Amazon: 128,80€

LG 25UM58

Caratteristiche:

Caratteristiche:

- Pannello IPS Ultra Wide da 25″

- Risoluzione Full HD (2560 x 1080)

- Refresh rate a 60 Hz

- Entrate video 2x HDMI con cavo HDMI incluso

- Non provvisto di audio integrato

Prezzo consigliato: 199€

Prezzo attuale su Amazon: 158,92€

AOC Q3279VWF

Caratteristiche:

Caratteristiche:

- Pannello MVA da 32″ con risoluzione Quad HD (2560 x 1440)

- Refresh rate a 75 Hz

- Entrate video HDMI, DisplayPort, DVI e VGA con cavi VGA, DisplayPort e HDMI inclusi

- Non provvisto di audio integrato

Prezzo consigliato: 299€

Prezzo attuale su Amazon: 204,99€

BenQ BL2420PT

- Pannello IPS da 24″

- Risoluzione Quad HD (2560 x 1440)

- Refresh rate a 60 Hz

- Entrate video HDMI, DisplayPort, DVI e VGA con cavi VGA e DVI inclusi

- Non provvisto di audio integrato

Prezzo consigliato: 409€

Prezzo attuale su Amazon: 253,89€

Lenovo L27q-10

Caratteristiche:

Caratteristiche:

- Pannello IPS da 27″

- Risoluzione Quad HD(2560 x 1440)

- Refresh rate a 75 Hz

- Entrate video HDMI e DisplayPort con con cavo HDMI incluso

- Non provvisto di audio integrato

Prezzo consigliato: 299€

Prezzo attuale su Amazon: 249€