Shadow of the Tomb Raider – Bellezza Letale

Il reboot di una delle serie più importanti della storia dei videogame, con l’intrinseca riscrittura di un’icona pop come Lara Croft, è stato un successo. Con l’ultimo capitolo di questa ideale trilogia, Shadow of the Tomb Raider, possiamo dirlo ma, diciamocela tutta: era più semplice sbagliare che fare bene.

Sin dal 2013, anno di debutto della nuova archeologa e delle sue avventure, Tomb Raider ha saputo a poco a poco abbattere i pregiudizi dei fan, portando capitoli interessanti dal punto di vista qualitativo (ricordiamo infatti l’eccellente Rise of the Tomb Raider) e soprattutto nella ricostruzione di una Lara Croft più umana, con un percorso di crescita che l’ha portata a essere (quasi) l’eroina che tutti conosciamo. Con Shadow of the Tomb Raider, il focus è incentrato sui tratti caratteriali e conseguenze negative dell’agire dell’archeologa, in un viaggio attraverso i suoi traumi infantili e insicurezze che finora, ha ben mascherato.

E se poi te ne penti?

Da quando Lara era formata da pochi e spigolosi poligoni, il suo agire non ha mai portato a conseguenze particolarmente fatali per il genere umano: si trovava una reliquia e la si prendeva, senza far troppe domande. Ma come Indiana Jones insegna, non è tutto oro ciò che luccica e questa volta, le conseguenza si faranno sentire. Sin dal prologo, assistiamo a un lato che poco si era visto nella trilogia: la superbia, il credere di essere fondamentale per il destino del mondo, unica protettrice dell’umana stirpe. Inutile dire come le cose prenderanno una brutta piega, dopo aver creduto di aver fatto la scelta giusta. L’avverarsi di un’antica profezia Maya getterà nel caos Messico e Perù e Lara, non potrà far altro che sentirsi in colpa per quanto sta avvenendo.

Comincia così un lungo cammino di redenzione per la protagonista, esplorando se stessa, la sua infanzia e il suo ruolo nel mondo, un cammino, come da tradizione, intriso di pericoli, a cominciare dalla Trinità, una presenza costante ma forse fin poco tangibile. L’avventura, tra esplorazione, stealth e azione frenetica, riesce a intrattenere anche grazie a una rinnovata regia non solo nelle cinematografiche cutscene ma anche in game, mostrando sempre i tratti più spettacolari o struggenti dell’azione. Da questo punto di vista Shadow of the Tomb Raider dà il meglio di se, trasponendo una campagna completa, suggestiva e contornata da missioni secondarie presenti nelle località che potremmo utilizzare quasi come degli hub. Queste missioni (forse un po’ troppo vecchia scuola), permettono, alla loro conclusione, lo sblocco di nuove armi ed equipaggiamento ma con l’effetto collaterale di frammentare fin troppo la narrazione. In qualche modo infatti, purché non obbligatorie, queste rallentano, sino quasi ad arrestare le quest principali, che appesantiscono ulteriormente il vero problema (e forse unico) di questo titolo: il ritmo. Se è vero che ci troviamo di fronte a un racconto maturo, con i giusti colpi di scena e la giusta dose di pathos, la narrazione non procede mai con ritmi costanti risultando veramente interessante solo in alcuni frangenti. In qualche modo, con le modifiche di gameplay adottate, non si è riusciti a bilanciare il tutto, anche perché allargare la natura del franchise verso l’open world, non sembra la scelta azzeccata.

A mostrare il fianco – a tratti – è anche la sceneggiatura, che riesce a esaltare molti momenti chiave ma anche a neutralizzare alcuni dei momenti più empatici della protagonista e dei comprimari, svolti forse con troppa fretta e superficialità.

Nonostante tutto però – soprattutto se avete giocato i due prequel – Shadow of the Tomb Raider vi terrà incollati allo schermo, proprio per poter vedere con i vostri occhi come una ragazza fragile, ingenua ma con tanti sogni nel cassetto, sia riuscita a divenire un donna forte, in grado di cambiare il proprio destino.

Sangue e Fango

Come prevedibile Shadow of the Tomb Raider è l’evoluzione (finale?) di quanto visto finora, dal 2013 a Rise of the Tomb Raider. Il cambio di location ha permesso alcune implementazioni, a cominciare dall’uso del rampino, necessario per raggiungere appigli altrimenti inaccessibili, agganciandosi alle pareti o permettendoci di salire o scendere in sicurezza. Questo attrezzo si dimostra utile anche nelle fasi stealth, in cui potremmo letteralmente impiccare il povero malcapitato tra i rami degli alberi, alla stregua di quanto avveniva in Assassin’s Creed III con protagonista Connor Kenway. Ma l’agire nell’ombra è facilitato anche dall’uso di altri nuovi elementi, come trappole da innestare nei cadaveri o speciali frecce in grado di mandare in delirio i nemici, uccidendosi a vicenda. L’approccio rimane dunque abbastanza libero e anche l’ambiente circostante arriva in soccorso, tra innumerevoli alberi e vegetazione in grado di fornire il giusto riparo. All’interazione ambientale consona, si aggiunge anche la possibilità di poter utilizzare del fango per ricoprire il corpo di Lara, rendendola invisibile (soprattutto la notte) a fugaci occhiate. È in questi frangenti che ci si toglie le grosse soddisfazioni, potendo sfruttare tutto l’ambiente a nostro vantaggio tra alberi, cespugli, pareti, alture e acqua. In questi frangenti Lara Croft è la cacciatrice, disposta a tutto pur di fermare la Trinità che, in questi frangenti, può contate su un’intelligenza artificiale leggermente sopra la media, in grado di stanarci con l’utilizzo di granate e di accerchiarci prendendoci alla sprovvista.

Come già accennato, l’avventura di Lara può essere arricchita da incarichi secondari più o meno interessanti, presenti all’interno delle città che visiteremo. In questi ambienti regna la tranquillità dove, interagire con gli abitanti, diventa fondamentale non solo per sbloccare nuovo equipaggiamento ma anche per scovare segreti e tesori sparsi per la mappa. Il problema di queste sezioni, benché ben congegnate, è che hanno l’effetto collaterale di diluire fin troppo la narrazione con elementi che in fin dei conti, non sono fondamentali. Aggiungere tali elementi, quasi da “open world”, in un’avventura nello stile di Tomb Raider è il problema più evidente: manca l’amalgama necessaria per apprezzare queste “pause” dalla narrazione principale e purché si tratti di location suggestive, la voglia di proseguire è fin troppo più grande rispetto a quella di eseguire piccoli incarichi secondari. Fortunatamente però, tornano, più grandi, più complesse e artisticamente più ispirate, le Tombe della Sfida e le Cripte. In questo terzo capitolo, esse assumono un ruolo attivo nello sviluppo della protagonista sbloccando, alla loro risoluzione, equipaggiamento (soprattutto vestiario) ma soprattutto abilità bonus e accessibili solo in questo caso, come la possibilità di trattenere maggiormente il respiro sott’acqua. Questo, regala finalmente la giusta importanza all’esplorazione delle tombe, ovviamente il punto focale dell’intero franchise, rispondendo alle critiche verso i capitoli precedenti in cui tutto ciò risultava del tutto secondario. Le abilità di Lara comunque, sono molteplici e suddivise in tre branche principali; la diversificazione delle capacità è la chiave per la sopravvivenza e in questo Crystal Dynamics ed Eidos Montreal hanno svolto un egregio lavoro dando l’opportunità al giocatore di “lavorare di fino” per personalizzare la nostra eroina. È tutto il gioco a invogliare a esplorare e a potenziale le abilità di Lara, sfruttando le capacità acquisite eventualmente nel new game + e nei contenuti aggiuntivi.

Dal punto di vista meramente action, dove la fasi shooting la fanno da padrone, non vi sono novità rilevanti: probabilmente il punto più debole del pacchetto, non riesce a risaltare quanto dovrebbe, contando su animazioni dedicate troppo legnose; cambiare arma, mirare, sparare e ricaricare non avviene con la giusta fluidità, finendo alle volte per preferire di gran lunga eliminare in silenzio i vari nemici. Nulla che intacchi l’avventura, ma forse è arrivato il momento di “svecchiare” queste sezioni, magari prendendo spunto dal suo rivale maschile (Nathan Drake, ndr).

Sinestesia

Come accaduto soltanto per la recensione di Hellblade: Senua’s Sacrifice, anche questa volta si parte dall’audio, un lavoro eccellente sotto tutti i punti vista. Le musiche, composte e dirette da Rob Bridgett, sono sempre adatte al contesto, creando atmosfere uniche non solo nei momenti riflessivi o nostalgici ma anche quando l’azione si fa via via più frenetica. Tutto viene enfatizzato anche dall’ausilio di alcuni strumenti tipici Maya, atti a ricreare probabilmente una delle migliori colonne sonore di questo 2018. Ma anche il doppiaggio (come da tradizione) non è da meno: l’ormai storica voce di Benedetta Ponticelli riesce a trasporre una Lara in costante conflitto con se stessa, attanagliata dai sensi di colpa senza andar mai sopra le righe. Tutti i dialoghi dell’archeologa restituiscono un personaggio reale, così come lo sono i comprimari, a cominciare dal suo fedele Jonah (Diego Baldoin), amico, guida e fratello maggiore di una Lara in via di maturazione. Ma il lavoro che lascia più di stucco è quello eseguito sugli effetti sonori e la loro tridimensionalità (consigliato vivamente l’utilizzo di un buon paio di headset). Tutti i suoni risentono delle varie superfici presenti, con un contrasto netto tra interni ed esterni; tutto è al posto giusto e in grado di generare ancor di più un forte senso di immedesimazione.

La parte meramente visiva invece spicca come una delle produzioni migliori degli ultimi anni e sicuramente il miglior Tomb Raider visto sinora. Tutti gli ambienti di gioco, dai piccoli villaggi alle intricate foreste godono di innumerevoli particolari, con l’attenzione minuziosa per i dettagli. Che siano baracche o semplici alberi, tutto è realizzato con cura, così come i modelli dei personaggi principali (Lara ovviamente splendida), esaltati da una regia che raramente è visibile in un videogioco. Il salto di qualità a livello narrativo, come detto, è forse mancato, ma il modo in cui vengono raccontate le vicende hanno subito un boost eccezionale, non solo per quanto riguardo le scene più adrenaliniche, mostrando ampie panoramiche in grado di risaltare l’impatto empatico con quanto avviene, ma anche un’attenzione particolare per i primi piani e durante alcuni momenti costruiti ad hoc per rimanere impressi per sempre nella mente dei giocatori. Tutto questo ben di dio, è purtroppo macchiato da qualche imprecisione nella fisica degli oggetti, qualche piccolo glitch e compenetrazione di troppo, quasi a segnalare un ultimo mancato intervento di “pulizia”. Nulla comunque che possa minare l’eccellente lavoro svolto da Crystal Dynimics.

In conclusione

L’ultimo capitolo della trilogia reboot dedicata a Lara Croft, riesce anche questa volta a fare centro. Nonostante la struttura narrativa soffra di alcuni cali di ritmo, dovuti anche all’introduzione di alcuni elementi di gameplay che forse mal si sposano con le caratteristiche dell’avventura proposta, il cammino di redenzione dell’archeologa più famosa al mondo riesce a trasmettere le giuste emozioni e il giusto grado di empatia. Il lavoro svolto da Crystal Dynamics dunque è di ottimo livello, riconfermando quanto di buono svolto dai precedenti capitoli, migliorando in toto tutta la parte tecnico-artistica, in cui spiccano audio e regia. Shadow of the Tomb Raider chiude il cerchio su una Lara molto diversa dall’icona pop degli anni ’90, ma sicuramente più vicina a noi, tralasciando ricchezza, l’atletismo di Ercole e la bellezza afrodisiaca. Anche questa Lara, ci piace.

Processore: Intel Core I7 4930K

Scheda video: Nvidia Gigabyte GTX760 4GB

Scheda Madre: MSi X79A

RAM: Corsair Vengeance 16GB

Sistema Operativo: Windows 10

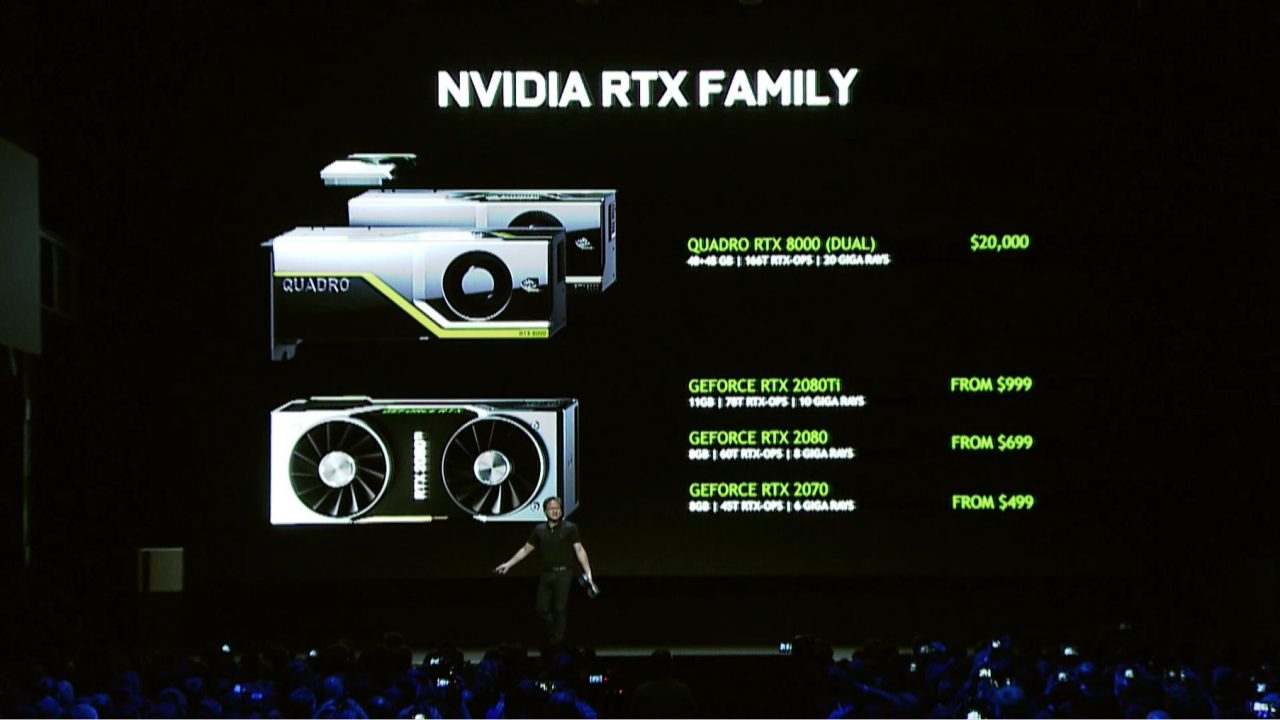

Chi volesse lasciare l’architettura Pascal per acquistare una scheda video Turing, dovrà fare i conti però con un prezzo che al momento è praticamente doppio, ma soprattutto perché sfruttare le nuove risorse richiede una forte limitazione in termini di risoluzione e frame rate, in particolare per quanto riguarda le 2070 e 2080.

Chi volesse lasciare l’architettura Pascal per acquistare una scheda video Turing, dovrà fare i conti però con un prezzo che al momento è praticamente doppio, ma soprattutto perché sfruttare le nuove risorse richiede una forte limitazione in termini di risoluzione e frame rate, in particolare per quanto riguarda le 2070 e 2080. Caratteristiche:

Caratteristiche: Caratteristiche:

Caratteristiche: Caratteristiche:

Caratteristiche: Caratteristiche:

Caratteristiche:

Caratteristiche:

Caratteristiche: